- Код статьи

- S042473880028256-0-1

- DOI

- 10.31857/S042473880028256-0

- Тип публикации

- Статья

- Статус публикации

- Опубликовано

- Авторы

- Том/ Выпуск

- Том 59 / №4

- Страницы

- 111-125

- Аннотация

Рассматривается алгоритм для реализации адаптивного поведения агентов в агент-ориентированных моделях (АОМ). Предполагается, что агент обладает некоторой внутренней параметрической моделью окружающего мира, которая порождает функцию правдоподобия для получаемой агентом информации об окружающем мире. Процесс адаптивного обучения агента за счет изменения параметров представлен в виде фильтрации в общей модели пространства состояний. В статье описан алгоритм SQ-фильтра, в котором используется линейная гауссовская плотность перехода и квадратичное по параметрам приближение для логарифмической функции правдоподобия. Данный алгоритм является модификацией классического фильтра Калмана. Он приложен к линейной регрессии с меняющимися параметрами. При поступлении агенту новой информации оценки параметров, в число которых входят как коэффициенты регрессии, так и дисперсия ошибки, корректируются оценки параметровадаптивным образом с учетом возможных выбросов. Работоспособность предложенной адаптивной регрессии проверена на двух экономических АОМ. Алгоритм показал хорошие результаты как в модели искусственного фондового рынка при предсказании агентами-трейдерами рыночной цены, так и в модели российской экономики при предсказании фирмами спроса на свою продукцию. С его помощью можно наделять агентов правдоподобным поведением без использования чрезмерно сложных расчетов.

- Ключевые слова

- адаптивное обучение, фильтр Калмана, агент-ориентированные модели

- Дата публикации

- 28.12.2023

- Год выхода

- 2023

- Всего подписок

- 10

- Всего просмотров

- 351

1. Введение

Традиционная теоретическая экономика, по сути, описывает «поведение неправдоподобно разумных людей в неправдоподобно простых ситуациях» (Leijonhufvud, 1993). Поведение обычных людей больше похоже на адаптивное, чем на полностью рациональное. Важность моделирования адаптивного поведения и адаптивного обучения давно осознана в макроэкономическом и финансовом моделировании (Leijonhufvud, 1993; Timmermann, 1993; Evans, Honkapohja, 2001; Carceles-Poveda, Giannitsarou, 2007; Sinitskaya, Tesfatsion, 2015). Предположение о том, что все агенты знают структуру экономического равновесия и действуют полностью оптимально на основе этого понимания, заменяется на более правдоподобное предположение, что агенты эконометрическими методами оценивают параметры своих внутренних моделей исходя из имеющихся данных. В частности, в современных исследованиях рассматриваются модели с обучением на основе (рекурсивного) метода наименьших квадратов, стохастического градиента и т.п. (Carceles-Poveda, Giannitsarou, 2007).

Очень актуальным использование адаптивного обучения является для агент-ориентированного моделирования. Агент-ориентированное моделирование — это распространившийся в последние годы подвид имитационного моделирования, помогающий изучению и прогнозированию явлений, происходящих в сложных экономических, социальных, биологических и других системах. Агент-ориентированные модели (АОМ) широко применяются в разных областях: дорожное движение (Nguyen et al., 2021), финансовые рынки (Iori, Porter, 2018), рынки электроэнергии (Weidlich, Veit, 2008), эпидемиология (Hunter, Namee, Kelleher, 2017), макроэкономика (Dawid H., Delli Gatti, 2018) и т.д.

В основе агентного подхода лежит индивидуальное поведение и взаимодействие агентов, входящих в изучаемую систему. Используемые в АОМ агенты — это компьютерные сущности внутри виртуальной системы — аналога моделируемой реальной системы, — которые производят некоторые действия и взаимодействуют с окружающей средой (в том числе с другими агентами). Агенты и содержащая их система имеют некоторые свойства (находятся в определенном состоянии). Агент может выбирать действия (из набора возможных) автономно от других агентов и от системы. Выбираемые действия приводят к изменению состояния системы во времени.

Как в любом имитационном моделировании, с АОМ проводятся вычислительные эксперименты в виде серии прогонов (испытаний)1. Результаты по многим прогонам, содержащим случайность, можно обобщить, собрав и проанализировав статистику. Изменяя параметры, меняя сценарии экспериментов, можно делать прогнозы о поведении изучаемой системы в разных условиях.

Одной из важнейших характеристик агента в АОМ является то, что он может воспринимать окружающую обстановку и принимать решения на основе определенных правил и алгоритмов поведения. В частности, в основе поведения может лежать максимизация некоторой целевой функции, параметры которой адаптивно меняются в зависимости от окружающей обстановки.

С одной стороны, компьютерные агенты должны быть достаточно похожими по основным характеристикам поведения на свои реальные прототипы. С другой стороны, в АОМ при большом числе агентов не стоит использовать слишком сложные алгоритмы обучения, требующие запретительно больших затрат времени для проведения расчетов. Поэтому агенты в АОМ не должны получать слишком большой объем информации и не должны быть неправдоподобно разумными. Другими словами, агенты в АОМ, как правило, будут характеризоваться несовершенством информации и неполной рациональностью, а их поведение будет адаптивным и достаточно простым.

В агент-ориентированном моделировании опробованы разные алгоритмы, отвечающие за адаптивное поведение агентов (Brenner, 2006; Weidlich, Veit, 2008; DeAngelis, Diaz, 2019), например алгоритм Эрева–Рота, Q-обучение, обучающиеся системы классификаторов, генетические алгоритмы, нейронные сети, различные алгоритмы обучения с подкреплением и прочие методы машинного обучения. В (Rand, 2006) показано сходство общей идеи адаптивного поведения в АОМ и машинного обучения. Для агента в АОМ вся остальная модель представляет собой окружающую среду. Обучаясь, агент видоизменяет свою модель окружающего мира за счет поступающих извне информации и подкрепляющих вознаграждений.

Для простоты изложения метода пусть работа АОМ представляется в виде последовательности периодов . У каждого агента есть некоторая модель окружающего мира, где окружающий мир — это остальные агенты и содержащая агентов система. Это будет параметрическая модель, описываемая параметрами . С точки зрения обучения агентов в течение каждого периода в АОМ происходит ряд событий (Rand, 2006):

- каждый агент получает информацию об окружающем мире , на ее основе он обновляет свою внутреннюю модель мира, корректируя параметры ;

- каждый агент решает на основе внутренней модели с параметрами , какое действие выбрать в текущем периоде;

- каждый агент осуществляет выбранные действия , что приводит к изменению состояний агентов и системы в целом.

Для реализации подобного рода адаптивного поведения в АОМ мы предлагаем использовать алгоритм, являющийся обобщением фильтра Калмана — SQ-фильтр. Первоначальная версия данного алгоритма была предложена для оценивания срочной структуры процентных ставок в статье (Авдеева, Цыплаков, 2015). В данной статье детально рассмотрена взаимосвязь SQ-фильтра с общей моделью пространства состояний. Показано, что SQ-фильтр можно рассматривать как приближенный алгоритм фильтрации, который эквивалентен полноценной процедуре фильтрации в случае гауссовской линейной модели пространства состояний.

Описанию модели пространства состояний и процедуры фильтрации для нее посвящен разд. 2. В разд. 3 описывается SQ-фильтр. В разд. 4 алгоритм конкретизирован для модели линейной регрессии с меняющимися параметрами, характеризующейся робастностью к выбросам. Предложена модификация алгоритма, делающая его более простым и удобным для прикладных вычислений. Наконец, в разд. 5 и 6 рассматривается использование такой адаптивной регрессии в двух экономических АОМ.

2. Модель пространства состояний

Процесс обучения агента в АОМ удобно представить в виде так называемой модели пространства состояний. Получаемая агентом информация отождествляется с наблюдаемым временным рядом . Используя эту информацию , агент адаптивно меняет параметры своей модели окружающего мира. Эти параметры с точки зрения модели пространства состояний представляют собой ненаблюдаемый вектор состояния . Связь вектора состояния с рядом описывается плотностью измерения, которую можно сформировать на основе внутренней модели окружающего мира агента. Процесс изменения во времени параметров описывается в виде плотности перехода.

Пусть — наблюдаемый (одномерный или многомерный) временной ряд. Типичное наблюдение представляет собой вектор . Модель для ряда сформулирована в терминах ряда состояний , где — вектор ненаблюдаемых компонент. Переменную называют переменной состояния.

Будем считать распределение и непрерывным. Совместная плотность в модели пространстве состояний строится из двух последовательностей условных плотностей (Tanizaki, 1996): плотность измерения , ; плотность перехода , . Начальную плотность можно рассматривать как частный случай плотности перехода при .

Важной характеристикой модели пространства состояний является то, что плотность измерения не зависит от . Точно так же плотность перехода не зависит от , и, таким образом, модель имеет марковский характер условно относительно предыстории .

Процесс, который можно рассматривать как обучение, в модели пространства состояний называется фильтрацией. Фильтрация происходит рекуррентно с учетом информации, имеющейся к данному моменту времени ( ), и представляет собой последовательность двух чередующихся шагов: шага прогнозирования и шага обновления.

Шаг прогнозирования. В момент для наблюдаемого ряда известны значения . Это дает информацию о значении переменной состояния в период (т.е. ), что выражается плотностью , которая берется с шага обновления периода . Эту же информацию можно использовать для прогноза переменной состояния на следующий период

прогноз наблюдаемого ряда на период в виде плотности —

где и определяются моделью.

Шаг обновления. После того как в период поступит новое наблюдение , можно скорректировать оценку состояния системы на основе :

Описанная общая модель пространства состояний не очень пригодна для проведения прикладных расчетов, так как в общем случае алгоритм фильтрации содержит многомерные интегралы. Однако в частном случае — гауссовской линейной модели пространства состояний — прямое использование интегралов можно заменить более простым алгоритмом с матричными вычислениями. В такой модели совместное распределение и является многомерным нормальным и плотность измерения примет вид — а плотность перехода — где ( ), ( ), ( ), ( ), ( ), ( ) — матрицы параметров модели, а через обозначена функция плотности многомерного нормального распределения . Для n-мерного распределения

Плотности, получаемые на шаге предсказания и шаге обновления гауссовской линейной модели, тоже многомерные нормальные:

Шаг предсказания дает плотность

Для функции плотности многомерного нормального распределения выполнено

Поэтому где

Шаг обновления дает плотность

Для функции плотности многомерного нормального распределения выполнено

Поэтому

Таким образом, в гауссовской линейной модели шаг предсказания задается формулами а шаг обновления — где мы обозначили

Эти рекуррентные формулы для , , , соответствуют классическому алгоритму фильтрации — фильтру Калмана (в одной из его возможных записей) (см., например, (Tanizaki, 1996)). Рекурсия начинается с

3. SQ-фильтр

Общие формулы фильтрации, записанные через многомерные интегралы, позволяют работать с произвольными моделями, но пользоваться ими напрямую слишком трудно. Фильтр Калмана — это удобный и несложный алгоритм для моделирования обучения агента2, но он позволяет работать только с очень ограниченным кругом моделей окружающего мира. Это связано с условием, что у наблюдаемой переменной нормальное условное распределение вида у которого математическое ожидание линейно по параметрам , а значение ковариационной матрицы точно известно заранее. Наша цель состоит в том, чтобы предложить более общий алгоритм, который был бы таким же простым, как фильтр Калмана, но позволял работать с более широким спектром моделей окружающего мира.

В гауссовском линейном случае плотность измерения равна . Будем рассматривать эту плотность как функцию правдоподобия, считая наблюдением, а — неизвестным параметром. Это не функция правдоподобия в обычном смысле, но в теории метода максимального правдоподобия (ММП) есть несколько понятий и результатов, которые нам здесь понадобятся.

Логарифмическая функция правдоподобия равна

При фиксированном это функция от . Направление увеличения функции задается ее градиентом В ММП этот градиент называется скор-вектором (score). Также важна матрица вторых производных (матрица Гессе): Эти функции связаны с величинами и , которые мы определили выше и которые входят в формулы шага обновления фильтра Калмана:

С точки зрения теории ММП, если — логарифмическая функция правдоподобия, то математическое ожидание ее градиента (скор-вектора) , рассчитанное по плотности равно нулю, а ковариационная матрица градиента — это так называемая информационная матрица. Чтобы отразить, что зависит от будем использовать более полную запись . В случае линейного гауссовского наблюдения информационная матрица равна

(Мы воспользовались тем, что ковариационная матрица многомерного нормального распределения с плотностью — это .) Таким образом, информационная матрица здесь совпадает с величиной .

Известный прикладной алгоритм фильтрации в случае нелинейных функций измерения и перехода — это так называемый расширенный фильтр Калмана, основанный на линеаризации нелинейных функций (см., например, (Tanizaki, 1996)). Мы воспользуемся приближенным алгоритмом, основанным на другом принципе — SQ-фильтром3. В нем вместо истинного логарифма плотности наблюдения используется квадратичная по переменной состояния функция

где и — это соответствующие градиент и информационная матрица: При приближение совпадает с по значению и первым производным. В общем случае вторые производные могут не совпадать, но по известному информационному тождеству ММП — это математическое ожидание матрицы вторых производных , рассчитанное по плотности :

Используя на шаге обновления вместо экспоненту указанного приближения, мы получаем те же рекуррентные формулы фильтрации, что и ранее для гауссовской линейной модели пространства состояний.

Рассмотренный алгоритм был первоначально предложен в статье (Авдеева, Цыплаков, 2015) для оценивания срочной структуры процентных ставок. Наиболее близкие аналоги описанного алгоритма — это модели временных рядов семейств GAS (Creal, Koopman, Lucas, 2013) и DSC (Harvey, 2013), также он напоминает семейство методов экспоненциального сглаживания (Hyndman et al., 2008; Лукашин, 2003) и метод стохастического градиента (Carceles-Poveda, Giannitsarou, 2007).

SQ-фильтр обладает рядом преимуществ по сравнению с указанными альтернативными методами. Методы экспоненциального сглаживания, стохастического градиента и метод калмановской фильтрации подходят только для очень узких классов переменных . Например, они не подходят для качественных переменных , имеющих дискретное распределение.

В этом смысле методы GAS и DSC более универсальные, поскольку основаны на скор-векторе произвольного распределения наблюдаемой переменной. SQ-фильтр можно рассматривать как их частный случай. Важным преимуществом SQ-фильтра по сравнению с GAS и DSC является то, что этот метод конкретизирует, как именно входит скор-вектор в рекурсии для меняющихся параметров. Например, если плотность наблюдения будет линейной гауссовской, то SQ-фильтр сведется к фильтру Калмана, который, как известно, обладает оптимальными свойствами. Методы GAS и DSC не дают здесь конкретных рекомендаций — на их основе можно сформулировать очень много разных алгоритмов, в том числе далеких от оптимальности.

SQ-фильтр позволяет руководствоваться при формулировке алгоритма обучения агента четкой процедурой. Сначала из содержательных соображений формулируется внутренняя модель окружающего мира для агента. Далее на основе данной модели формулируется вероятностная параметрическая модель для наблюдаемой переменной . Это дает плотность измерения и скор-вектор . По плотности измерения аналитическим интегрированием вычисляется информационная матрица . Скор-вектор и информационная матрица используются в формулах SQ-фильтра для обучения агента.

К недостаткам SQ-фильтра можно отнести то, что для получения матрицы требуется интегрирование. В то же время для многих достаточно важных и полезных случаев интегрирование может быть произведено аналитически, что служит важным преимуществом SQ-фильтра по сравнению с фильтрацией в общей модели пространства состояний.

То что SQ-фильтр в общем случае является только приближением для точной фильтрации, не является принципиальным недостатком, поскольку правдоподобность и простота поведения агента более важны, чем полная оптимальность его поведения.

Один из самых удобных типов моделей окружающего мира для алгоритмов обучения — это линейные модели регрессии, поэтому конкретизируем описанный общий SQ-фильтр для случая регрессии с меняющимися параметрами. Для регрессионной ошибки выберем семейство распределений с толстыми хвостами. Это один из случаев, когда информационную матрицу для SQ-фильтра можно вычислить аналитически.

4. SQ-фильтр для регрессии с меняющимися параметрами

Рассмотрим линейную регрессионную модель общего вида , где — моделируемая переменная, — вектор-строка объясняющих переменных длины (обычно содержит единицу, отвечающую за константу). Переменные для простоты будем считать фиксированными (хотя случайные регрессоры и лаги ряда не представляют проблемы). Пусть коэффициенты регрессии и дисперсия ошибки меняются во времени. Дисперсия зависит от показателя волатильности . Предположим, что динамика меняющихся параметров задается линейным гауссовским процессом марковского вида с плотностью перехода где ковариационная матрица блочно-диагональная:

В использованных ранее обозначениях .

Введем нормированную ошибку регрессии т.е. ошибку с нулевым математическим ожиданием и нулевой дисперсией. При этом

Для достижения робастности (устойчивости) регрессии к возможным выбросам (резко выделяющимся значениям) предположим, что имеет t-распределение Стьюдента4 с степенями свободы, нормированное к единичной дисперсии, так что

где — обычное t-распределение с плотностью

Здесь мы учли, что дисперсия t-распределения равна . С учетом масштабирования плотность измерения в данном случае имеет вид

Указанные плотности перехода и измерения задают модель регрессии с меняющимися параметрами. Найдем для данной модели SQ-фильтр. Соответствующая логарифмическая функция правдоподобия измерения равна

где , или

Градиент функции равен

Вектор получим, подставив в данную формулу вместо и вместо .

Информационную матрицу измерения найдем как ковариационную матрицу с учетом того, что имеет распределение Стьюдента, а — распределение Фишера со степенями свободы 1 и . Имеется известная связь между распределением Фишера и бета-распределением, из которой следует что где — бета-распределение с параметрами и .

Поскольку имеет симметричное распределение, матрица будет блочно-диагональной. Используя формулы моментов бета-распределения, получим

Предположим, что матрица является блочно-диагональной. Это свойство будет сохраняться для матриц и на дальнейших шагах SQ-фильтра. Введем соответствующие обозначения для диагональных блоков

Тогда уравнения SQ-фильтра можно разделить на уравнения для коэффициентов и для волатильности :

Произведем с этими уравнениями следующие преобразования. Во-первых, уберем волну над переменными, чтобы разгрузить обозначения. Во-вторых, заметим, что по свойствам матричных операций имеем где В-третьих, исключим из уравнений , и (предсказание для нас важнее, чем обновление). Тем самым мы получили уравнения5:

Технические подробности численной реализации данного алгоритма приведены в Приложении.

Если — константа, то последовательность будет сходящейся. Таким образом, на практике можно упростить рекурсию для , исключив из алгоритма :

где — половина соответствующего предела, коэффициент сглаживания.

Робастность фильтра к выбросам связана с тем, что квадрат в знаменателе в рекурсиях для и приглушает влияние больших по модулю значений , причем это проявляется в наибольшей степени при малых значениях параметра степеней свободы . В пределе при больших (при приближении распределения ошибок регрессии к нормальному) такая робастность теряется.

5. Обучение по адаптивной регрессии в модели искусственного фондового рынка

Модель была разработана в Институте Санта-Фе (Нью-Мексико, США) в конце 1980 – начале 1990-х годов. При описании модели мы будем опираться на статью (Arthur et al., 1997)6. Реализация несколько модифицированной модели на языке Objective-C в рамках агент-ориентированного инструментария Swarm имеется в свободном доступе7.

7. См. >>>>

Модель действует в дискретном времени ( ). На рынке идет торговля только одним видом акций с экзогенно определяемыми случайными дивидендами . Имеется также безрисковый актив с однопериодной ставкой . Участниками фондового рынка являются «трейдеры» и «специалист» (аукционист). Трейдеры могут покупать и продавать акции (выбирать ). При этом можно открывать короткую позицию и брать в долг по ставке . Акции безгранично делимы. Всего имеется акций (по числу трейдеров). Каждый период трейдер распределяет имеющееся у него богатство между деньгами и акциями.

Если в момент трейдер обладает богатством , цена акции равна и он включает в свой портфель акций, то в безрисковый актив будет вложена сумма . В период вложения в акции дадут дивиденды . Также можно будет продать акции по цене , а вложения в безрисковый актив дадут проценты по ставке . Таким образом, в период трейдер будет обладать богатством

Предполагается, что при составлении портфеля (выборе ) трейдер максимизирует ожидаемую полезность от богатства в следующем периоде исходя из той информации, которой обладает на момент , т.е. он максимизирует величину по где — условное математическое ожидание, соответствующее представлениям инвестора в момент о распределении , а — функция полезности.

Предполагается, что в соответствии с представлениями трейдера величина имеет нормальное условное распределение с математическим ожиданием и дисперсией , а функция полезности трейдера относится к семейству функций CARA (constant absolute risk aversion — с постоянным абсолютным неприятием риска), т.е.

Трейдеры в модели идентичны по функции полезности и алгоритму поведения, но каждый из них имеет свои ожидания и использует их для формирования спроса. При указанных предположениях оптимальное решение зависит от двух первых условных моментов величины по формуле

При сделанных предположениях спрос на акции устроен так, что не зависит от богатства. Это позволяет оставить изменение богатства трейдеров за рамками модели.

В течение каждого периода происходит следующая последовательность событий:

- в начале периода генерируется очередной дивиденд по модели авторегрессии первого порядка где независимая ошибка имеет нормальное распределение ;

- трейдеры используют , а также предысторию дивидендов и цен ( ), чтобы сформировать прогноз для суммы дивидендов и цены в следующем периоде, т.е. для величины . Прогноз — это формула точечного прогноза и измеритель точности этого прогноза

- далее каждый трейдер рассчитывает свою функцию спроса . При этом он использует в качестве и в качестве , так что его спрос оказывается равным

- трейдеры сообщают свои функции спроса специалисту, который вычисляет равновесную цену , удовлетворяющую уравнению Это будет цена на акции в период

- каждый трейдер реализует имеющиеся у него акции по цене , а затем включает в свой портфель акций;

- происходит обновление параметров прогнозных алгоритмов трейдеров, так как прогнозы предыдущего периода теперь можно сравнить с фактически реализовавшейся величиной .

По условиям модели прогноз линеен по : и прогнозы трейдеры формируют путем обучения. В исходной модели у каждого трейдера есть набор из предикторов, с помощью которых вычисляются , . Предикторы работают по принципу обучающейся системы классификаторов (learning classifier system). Выбор предиктора и его видоизменение определяются генетическими алгоритмами, показатель точности меняется по формуле простого экспоненциального сглаживания. Подробности алгоритмов обучения исходной модели мы здесь не рассматриваем (Arthur et al., 1997).

Работа модели определяется рядом параметров, которые перечислены в табл. 1.

Таблица 1. Базовая конфигурация модели искусственного фондового рынка

| Атрибут модели | Значение |

| Число агентов (трейдеров) N | 25 |

| Количество акций N | Совпадает с числом агентов |

| Средний дивиденд | 10 |

| Коэффициент авторегрессии для дивидендов | 0,95 |

| Дисперсия ошибки для дивидендов | 0,0743 |

| Безрисковая ставка за период | 0,1 |

| Коэффициент функции полезности CARA | 0,5 |

Заметим, что у рассматриваемой агент-ориентированной модели искусственного фондового рынка имеется теоретический аналог — однородное равновесие с рациональными ожиданиями (Arthur et al., 1997). В этом равновесии цена линейно связана с дивидендами где

Прогноз как функция имеет вид где а соответствующая условная дисперсия равна

Результаты работы агент-ориентированной модели можно непосредственно сопоставить с этим теоретических равновесием. Априори не вполне понятно, покажет ли АОМ результаты, близкие к теоретическим. «Характерной чертой экономической среды является то, что она состоит из агентов, каждый из которых может стараться изучать эту окружающую среду и тем самым то, что делают другие агенты. Это быстро становится очень сложным, и совсем не ясно, будет ли поведение индивидуумов «совместно эволюционировать» к чему-то, соответствующему теоретическому решению для статического равновесия» (Kirman, 2011).

В отличие от (Arthur et al., 1997) мы используем в качестве алгоритма обучения SQ-фильтр. Цена играет роль наблюдения . Формулу прогноза возьмем линейного вида, но более общую, с разными коэффициентами для цены и дивидендов: Это дает регрессию с меняющими коэффициентами и меняющейся дисперсией , которую можно использовать в качестве Остальные параметры фильтра были выбраны следующими: , , . Первоначальные значения коэффициентов выбирались случайно, но достаточно близкими к тем, которые получаются в равновесии с рациональными ожиданиями, если сделать прогнозную функцию линейной не по , а по дивидендам :

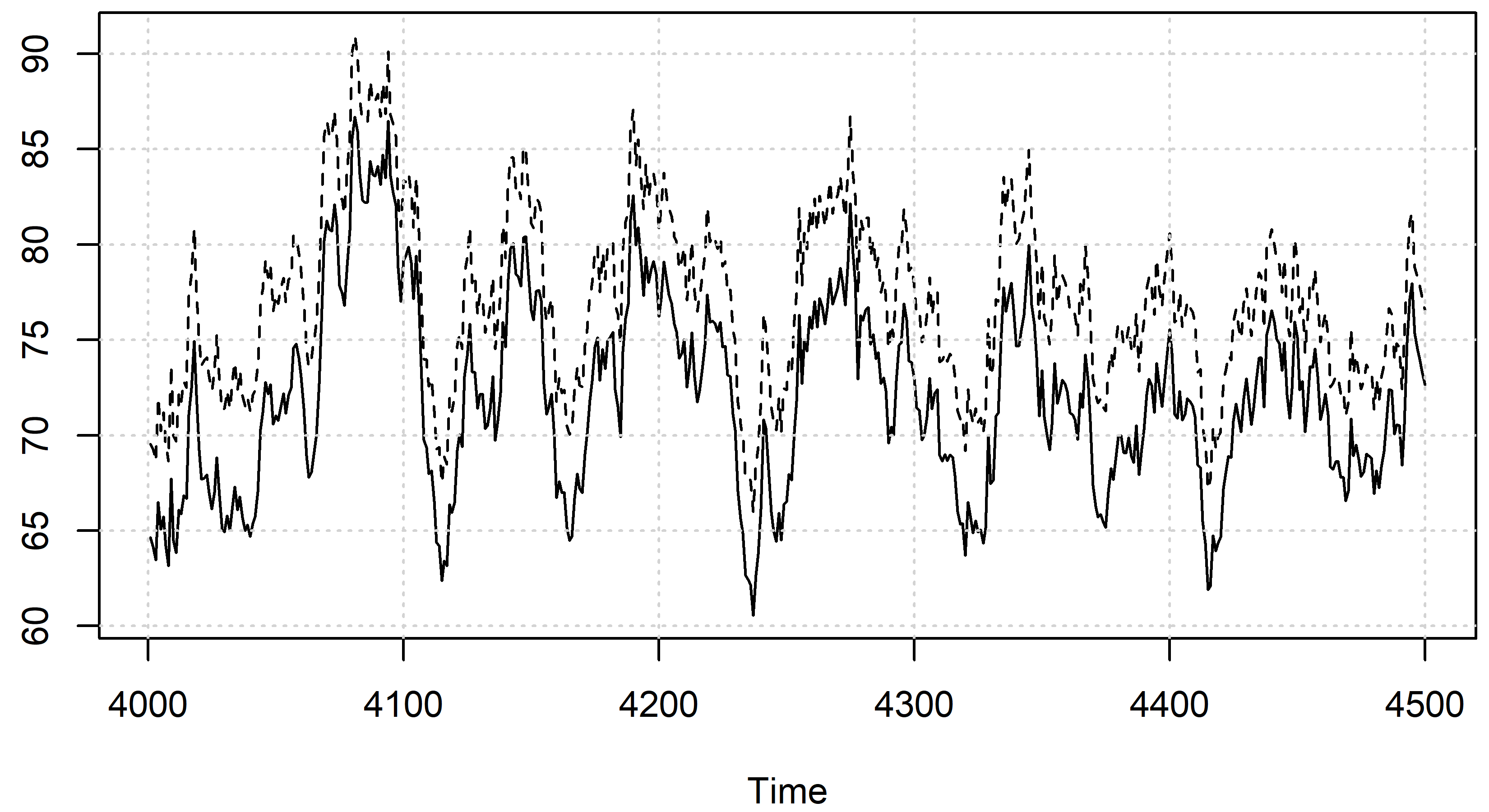

Рис. 1. Динамика коэффициентов

Рис. 2. Динамика выборочного среднеквадратического отклонения коэффициентов ati2 по агентам

Расчеты по описанной АОМ продемонстрировали следующие основные эффекты.

- Параметры разных агентов сближаются между собой. Это связано с тем, что агенты используют одинаковые алгоритмы обучения и получают одинаковую информацию (рис. 1–2).

- Оценка колеблется около нулевого уровня, т.е. цена не очень информативна для агентов при предсказании .

- Параметры не сходятся к постоянному уровню, а колеблются в достаточно широких пределах, поскольку агенты постоянно обучаются.

- Оценки дисперсии в среднем выше теоретического аналога . Это связано с эффектом из п. 3.

- Цена в среднем несколько ниже теоретической цены (рис. 3). Более того, разница положительно коррелирует с оценками дисперсии у агентов (коэффициент корреляции примерно 0,45). Это объясняется указанным различием дисперсий.

Рис. 3. Типичное поведение двух рядов цен: модельной цены (сплошная линия) и «теоретической» (пунктир)

Результаты экспериментов демонстрируют, что предложенный алгоритм обучения неплохо работает и обладает правдоподобными свойствами. Однако в рассмотренной постановке модели слабо проявляется тот факт, что каждый агент автономен по поведению и обучению.

Более интересные результаты получаются, если наделить каждого агента в период некоторой частичной информацией о будущем значении дивиденда , причем так, чтобы информация была разная у разных агентов. Не вдаваясь в детали такой модификации модели фондового рынка, отметим, что предложенный алгоритм достаточно правдоподобно работает и в этом случае. А именно оценки параметров у разных агентов уже не сближаются. Оценка параметра колеблется около достаточно высокого положительного уровня, что говорит о том, что цена в данной модификации становится информативной при предсказании .

6. Прогнозы спроса в агент-ориентированной модели российской экономики

Рассматриваемый в статье алгоритм был использован в агент-ориентированной многорегиональной межотраслевой модели (АОМММ), описывающей российскую экономику (см., например, (Цыплаков, 2022) и ссылки там же). В этой модели действует, в частности, механизм торговли, в рамках которого продавцы назначают цены, а покупатели в соответствии с некоторым алгоритмом, включающим элемент случайности, выбирают количества товаров, приобретаемых у тех или иных продавцов. Таким образом, фирмам-продавцам требуется выбрать, какую цену установить.

Спрос на продукцию фирмы зависит от цен, установленных ею и ее конкурентами. Алгоритм покупательского выбора устроен так, что у продавца с более низкой ценой спрос при прочих равных условиях в среднем выше. Кроме того, на общий спрос покупателя-домохозяйства цена также оказывает отрицательное влияние. В целом средний спрос на продукцию фирмы можно представить как воображаемую убывающую функцию ее цены .

В каждом периоде фирма имеет некоторые производственные мощности , ограничивающие сверху ее объем производства . Также фирма обладает некоторым запасом готовой продукции , который она стремится поддерживать на достаточно высоком уровне. Если — спрос на продукцию, то за период запасы готовой продукции изменятся на величину . Выбирая цену продукции и объем производства , фирма может влиять на спрос, запасы и свою прибыль. В модели фирмы используют оценки функции спроса на свою продукцию для планирования цены и объема производства. По какому именно принципу они это делают, мы здесь не будем обсуждать подробно. Важно, чтобы оценка спроса была достаточно точной и чтобы она адаптировалась к текущей ситуации на рынке. Для решения этой задачи применен алгоритм адаптивной регрессии.

Модель регрессии для отдельной фирмы имеет вид где — небольшая добавка, позволяющая работать с нулевым спросом, — ожидаемая средняя цена фирм-конкурентов. Для прогнозирования цен конкурентов применяется авторегрессия первого порядка (с тем же адаптивным алгоритмом): В качестве в модели спроса используется прогноз из этой последней модели.

Были проведены эксперименты по тестированию адаптивных свойств предлагаемого алгоритма. Был взят сценарий сдвига в потребительских предпочтениях, приводящий к изменению потребительского спроса в затронутых отраслях. В АОМММ по умолчанию используются функции полезности Кобба–Дугласа, для которых, как известно, коэффициенты определяют доли отдельных товаров в расходах домохозяйства. За счет увеличения коэффициента для товара 2 (отрасль «Обработка) и уменьшение коэффициента для товара 5 («Услуги») на 5 процентных пунктов в период были изменены доли соответствующих товаров в расходах. Это повлияло на спрос в этих двух отраслях. Для стабилизации рынков после сдвига требовались изменения в функциях спроса отдельных фирм.

На рис. 4 показана динамика объемов продаж и производства нескольких фирм в отрасли 2 для одного прогона модели. Размеры фирм существенно различаются. Это требует соответствующего установления цен на продукцию — при прочих равных условиях цена на более крупной фирме должна быть более низкой. На этапе инициализации модели этот эффект был учтен, но фирмам все равно потребовался некоторый период обучения, поскольку кроме цены спрос также зависит от местоположения фирмы, ее рынка сбыта и других факторов.

Наблюдается повышательный тренд в объемах производства, связанный с ростом относительной цены продукции в этой отрасли и ростом рентабельности. Объемы продаж следуют этому же тренду. Сразу после периодов и продажи для некоторых фирм опережали производство, но адаптация функций спроса привела к постепенному выравниванию этого перекоса.

Рис. 4. Продажи и производство нескольких фирм в отрасли 2

Такую же картину можно наблюдать в агрегированной динамике объемов продаж, производства отрасли 2 (рис. 5). Запасы готовой продукции в два указанных периода адаптации снижались, но затем возвращались к требуемому уровню.

Рис. 5. Продажи, производство и запасы готовой продукции в отрасли 2 в целом

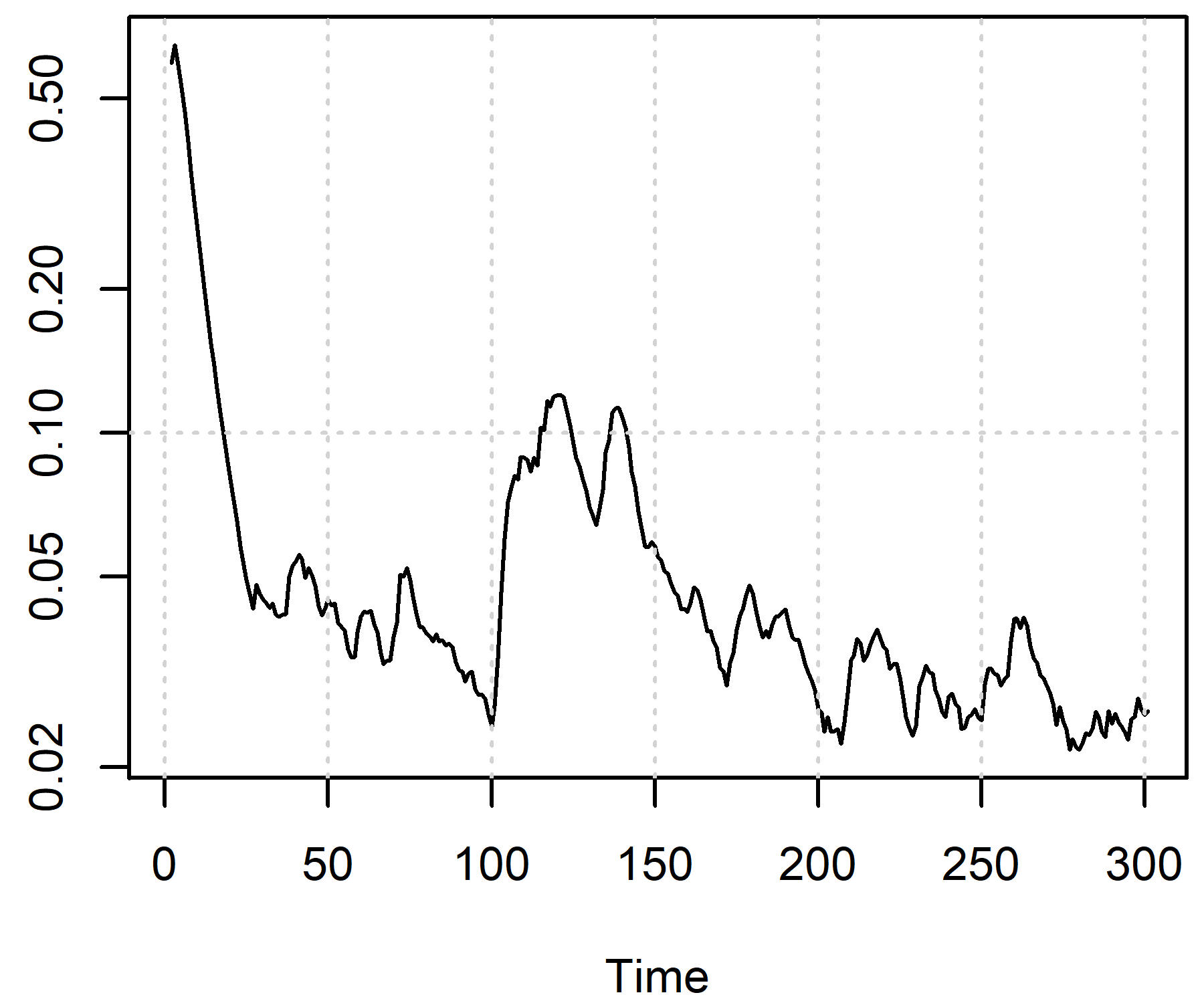

Рис. 6. Средняя неопределенность спроса в отрасли 2

Среднеквадратическое отклонение ошибки в регрессии для спроса равно Этот ряд можно рассматривать как показатель неопределенности, связанный с предсказанием спроса. В модели АОМММ для мониторинга рассчитывается среднее геометрическое этого показателя, взвешенное по объемам продаж фирм. Динамика средней неопределенности спроса в отрасли 2 показана на рис. 6. После начала работы модели неопределенность спроса находилась на высоком уровне, что связано с тем, что фирмы еще недостаточно изучили свой спрос. Затем неопределенность падает, а после периода повышается, но до более низкого уровня, чем вначале. Постепенно неопределенность опять падает, так как происходит обучение и фирмы более точно предсказывают спрос на свою продукцию.

7. Заключение

В статье предложен универсальный алгоритм обучения для агент-ориентированных моделей. Основные требования к применимости этого алгоритма — SQ-фильтра — состоят в том, чтобы внутренняя модель мира агента порождала функцию правдоподобия наблюдаемой переменной, которая гладко зависит от параметров, и чтобы можно было в явном виде вычислить соответствующую информационную матрицу. Это позволяет говорить о применимости SQ-фильтра в самых разных видах АОМ (хотя и требуется работа по подбору подходящей удобной для расчетов спецификации зависимости). В частности, хотя здесь это и не обсуждалось, наблюдаемая агентом переменная может быть дискретной, качественной и т.п.

В статье показаны возможности SQ-фильтра на примере моделей окружающего мира, приводящих к линейным регрессиям с t-распределением ошибки. Предложенная адаптивная регрессия хорошо зарекомендовала себя в АОМ при предсказании рыночной цены и при предсказании спроса на продукцию фирмы. В модели искусственного фондового рынка, где агенты-трейдеры обучаются по предложенному алгоритму, обучение происходит вполне качественно и порождает правдоподобные эффекты. В АОМ российской экономики агенты хорошо адаптируются к меняющемуся спросу. В целом приведенные примеры продемонстрировали, что, используя подобный алгоритм, можно наделять агентов правдоподобным поведением, не перегружая модель чрезмерно сложными вычислениями.

Заметим, что в статье за кадром остался вопрос о том, какими выбирать параметры используемых алгоритмов обучения. В (Arthur, 1991) предлагается подход, при котором решения агентов определяются параметризованными алгоритмами принятия решений, и эти алгоритмы подбираются и калибруются таким образом, чтобы поведение агентов достаточно близко соответствовало тому, что наблюдается в реальности. Можно ожидать, что прикладные модели, использующие таких «откалиброванных агентов», будут давать более реалистичные предсказания.

Приложение

Использование QR-разложения для реализации регрессионного SQ-фильтра

Сложности с реализацией описанного регрессионного SQ-фильтра могут возникнуть из-за вычислительной нестабильности при расчетах по рекуррентной формуле для ковариационной матрицы оценок коэффициентов Данная матрица при вычислении непосредственно по указанной формуле может оказаться неположительно определенной. Опишем здесь вычислительный прием, который хорошо зарекомендовал себя на практике — использование QR-разложения.

Пусть — квадратный корень из ; — квадратный корень из : Обозначим

Тогда

Применим к матрице QR-разложение, т.е. представим ее в виде где матрица является ортогональной ( , ), а — верхней треугольной. При этом Представим в блочном виде, соответствующем структуре :

Приравнивая и , получим: откуда (берем положительный корень), и Таким образом, верхняя треугольная матрица имеет вид

Описанный прием позволяет с помощью стандартного для матричных вычислений QR-разложения получить необходимые для регрессионного SQ-фильтра величины , и не теряет положительной полуопределенности.

Библиография

- 1. Авдеева О.А., Цыплаков А.А. (2015). Метод адаптивного оценивания срочной структуры процентных ставок // Экономический журнал ВШЭ. Т. 19. № 4. С. 609–639.

- 2. Лукашин Ю.П. (2003). Адаптивные методы краткосрочного прогнозирования временных рядов. М.: Финансы и статистика.

- 3. Цыплаков А.А. (2022). Стационарность и рост в агент-ориентированной модели экономи-ки // Мир экономики и управления. Т. 22. № 1. С. 84–102.

- 4. Шеннон Р. (1978). Имитационное моделирование систем – искусство и наука. М: Мир.

- 5. Arthur W.B. (1991). Designing economic agents that act like human agents: A behavioral ap-proach to bounded rationality. The American Economic Review, 81, 2, 353–359. Papers and Proceedings of the Hundred and Third Annual Meeting of the American Economic Associa-tion, May, 353–359.

- 6. Arthur W.B., Holland J., LeBaron B., Palmer R., Tayler P. (1997). Asset pricing under endo-genous expectations in an artificial stock market. In: W.B. Arthur, S. Durlauf, D. Lane (eds.). The economy as an evolving complex system II. Reading: Addison-Wesley, 15–44.

- 7. Brenner T. (2006). Agent learning representation: Advice on modelling economic learning. Сh. 18. Handbook of Computational Economics, 2, 895–947.

- 8. Carceles-Poveda E., Giannitsarou C. (2007). Adaptive learning in practice. Journal of Economic Dynamics & Control, 31, 2659–2697.

- 9. Creal D., Koopman S.J., Lucas A. (2013). Generalized autoregressive score models with applica-tions. Journal of Applied Econometrics, 28, 5, 77–795.

- 10. Dawid H., Delli Gatti D. (2018). Agent-based macroeconomics. In: Handbook of computational economics. Vol. 4. C. Hommes, B. Lebaron (eds.). SSRN Electronic Journal, 63–156. DOI: 10.2139/ssrn.3112074

- 11. DeAngelis D.L., Diaz S.G. (2019). Decision-making in agent-based modeling: A current review and future prospectus. Frontiers in Ecology and Evolution, 6, 237.

- 12. Evans G.W., Honkapohja S. (2001). Learning and expectations in macroeconomics. Princeton: Princeton University Press.

- 13. Harvey A.C. (2013). Dynamic models for volatility and heavy tails: With applications to financial and economic time series. Econometric society monograph. Cambridge: Cambridge University Press.

- 14. Hunter E., Namee B.M., Kelleher J.D. (2017). A taxonomy for agent-based models in human in-fectious disease epidemiology. Journal of Artificial Societies and Social Simulation 20, 3, 2. Available at: https://www.jasss.org/20/3/2.html DOI: 10.18564/jasss.3414

- 15. Hyndman R.J., Koehler A.B., Ord J.K., Snyder R.D. (2008). Forecasting with exponential smoothing: The state space approach. New York: Springer.

- 16. Iori G., Porter J. (2018). Agent-based modeling for financial markets. In: The Oxford handbook of computational economics and finance. S.-H. Chen M. Kaboudan, Y.-R. Du. (eds.). New York: Oxford University Press, 635–666. DOI: 10.1093/oxfordhb/9780199844371.013.43

- 17. Kirman A. (2011). Learning in agent-based models. Eastern Economic Journal, 37, 20–27.

- 18. Lange K.L., Little R.J., Taylor J.M.G. (1989). Robust statistical modeling using the t distribution. Journal of the American Statistical Association, 84, 881–896.

- 19. Leijonhufvud A. (1993). Towards a not-too-rational macroeconomics. Southern Economic Jour-nal, 60, 1, 1–13.

- 20. Nguyen J., Powers S.T., Urquhart N., Farrenkopf T., Guckert M. (2021). An overview of agent-based traffic simulators. Transportation Research Interdisciplinary Perspectives 12, December, 100486.

- 21. Rand W. (2006). Machine learning meets agent-based modeling: When not to go to a bar. C.M. Macal, D.L. Sallach, M.J. North (eds.). Proceedings of the Agent 2006 conference on social agents: Results and prospects. Argonne National Laboratory and University of Chica-go, Chicago, 51–59.

- 22. Shannon R.E. (1976). Simulation modeling and methodology. WSC '76: Proceedings of the 76 Bi-centennial conference on winter simulation, December, 9–15.

- 23. Sinitskaya E., Tesfatsion L. (2015). Macroeconomies as constructively rational games. Journal of Economic Dynamics & Control, 61, 152–182.

- 24. Tanizaki H. (1996). Nonlinear filters: Estimation and applications. 2nd ed. Berlin, Heidelberg: Springer-Verlag.

- 25. Tesfatsion L. (2012). Detailed notes on the Santa Fe artificial stock market (ASM) model. Availa-ble at: http://www2.econ.iastate.edu/tesfatsi/SFISTOCKDetailed.LT.htm

- 26. Timmermann A.G. (1993). How learning in financial markets generates excess volatility and pre-dictability in stock prices. The Quarterly Journal of Economics, 108, 4, 1135–1145.

- 27. Weidlich A., Veit D. (2008). A critical survey of agent-based wholesale electricity market models. Energy Economics 30, 1728–1759.